[ad_1]

Институт искусственного интеллекта AIRI опубликовал код первой российской мультимодальной языковой модели OmniFusion 1.1, которая может работать не только с текстом. Исследователи расширили возможности нейросети благодаря внедрению новых данных: изображений, а в перспективе – видео-, аудио- и 3D-материала.

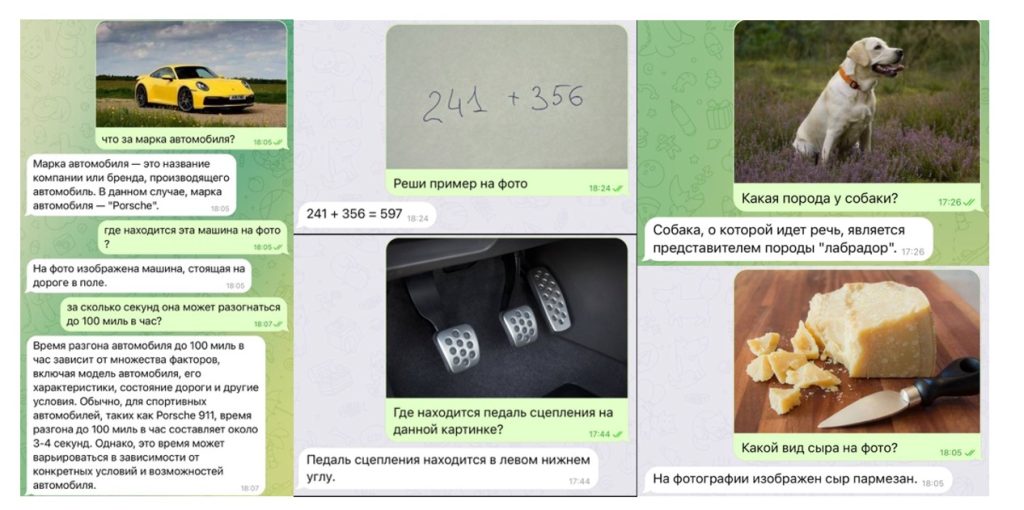

OmniFusion 1.1 способна работать с изображениями: объяснять содержание картинок, анализировать карты местности, выявлять проблемы на медицинских снимках, решать задачи, давать инструкции и подбирать варианты блюд по фотографиям продуктов. Нейросеть подскажет породу собаки, марку автомобиля, определит вид сыра и найдет педаль тормоза по картинке. Эта модель воспринимает информацию на русском языке и может вести текстовую и визуальную беседу.

Мультимодальная нейронная сеть OmniFusion 1.1 основана на объединении предварительно обученной большой языковой модели и визуальных энкодеров. Это позволяет преобразовывать информацию на изображении в числовой вектор, так называемый эмбеддинг. Группа FusionBrain AIRI вместе с учеными команд Sber AI и SberDevices продолжают работать над улучшением нейросети.

Текст: Виктория Родичева

Изображения: Freepik; Институт искусственного интеллекта AIRI

[ad_2]

Источник