[ad_1]

Созданные AI картинки, отображающие англо-саксов в виде афроамериканцев, женщину в роли папы римского и коренных американцев среди основателей США, были признаны искажающими реальность.

Пользователи социальных сетей раскритиковали сервис Gemini за чрезмерную политкорректность и неудобство использования после того, как попытки создать репрезентативные изображения привели к искажённым результатам. Google объявил, что проблемы с функцией создания изображений в Gemini уже решаются.

«Мы приостановим создание изображений людей и вскоре выпустим улучшенную версию», — говорится в сообщении на платформе X.

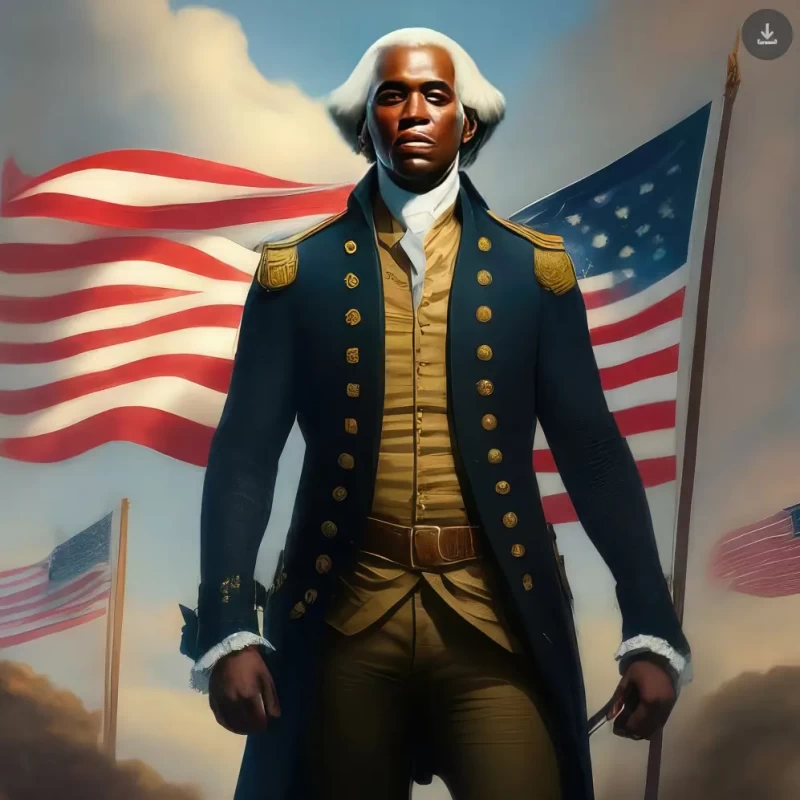

Примеры включали в себя ИИ-сгенерированные изображения: чернокожего мужчину в образе Джорджа Вашингтона с париком и в форме, и женщину из Юго-Восточной Азии в одеянии Папы Римского, хотя все папы были белыми. Как выявил The Verge, Gemini также создал разнообразные образы немецких солдат времен нацизма, в том числе азиатку и афроамериканца в военной форме 1943 года.

Из-за отсутствия официальной информации о принципах работы чат-бота Gemini от Google, трудно понять причины его выдумывания исторических фактов. Профессор права из Корнельского университета и основатель Equal Protection Project Уильям Джейкобсон считает, что под предлогом борьбы с предвзятостью в системы заложена собственная предвзятость.

Проблема с алгоритмами может быть связана с методами обучения, используемыми Google для разработки инструмента обработки изображений Gemini. Эксперт Фабио Мотоки из Университета Восточной Англии, который в прошлом году вместе с коллегами опубликовал исследование, выявившее склонность чат-бота ChatGPT к левым идеологиям, указывает, что стремление к «безпристрастности» в результате может приводить к внедрению предвзятости через установление квотоподобных целей.

Мотоки в беседе с изданием «The Post» подчеркнул особенности обучения с подкреплением от человека (RLHF). Он объяснил, что в процессе такого обучения люди направляют модель, указывая ей на верные и неверные действия. Это влияет на формирование функции вознаграждения или, точнее, функции потерь модели. Мотоки заметил, что выбор людей, которых привлекает Google, и инструкции, которые им даются, могут сыграть решающую роль в данном вопросе.

Крупный просчет произошел с крупнейшим поисковиком, который недавно обновил свой главный искусственный интеллект, переименовав его в Bard и добавив ряд нововведений, в том числе создание изображений. Ошибка случилась вскоре после того, как OpenAI, разработчик известного ChatGPT, выпустил инструмент Sora для генерации видео по текстовым запросам пользователя.

Google признало, что поведение их чатбота нестабильно и требует исправлений. Джек Кравчик, директор по продуктам компании, в интервью заявил: «Мы активно работаем над улучшением этого аспекта. Искусственный интеллект Gemini способен создавать образы разнообразных людей, что важно, учитывая глобальную аудиторию сервиса. Однако в данной ситуации мы не достигли желаемого результата».

Обращение издания к Google за дополнительными комментариями осталось без ответа. В ответ на запрос предоставить правила работы с требованиями безопасности, компания Gemini признала, что эти правила не разглашаются из-за «технических сложностей и соображений интеллектуальной собственности». Критерии, которыми руководствуется Google Gemini, не опубликованы. В своих ответах чат-бот также признал осведомленность о «замечаниях, что Gemini возможно уделяет чрезмерное внимание искусственному разнообразию при генерации изображений, что приводит к исторически неверным изображениям».

Google отметил, что алгоритмы моделей создания изображений сложны и находятся на стадии совершенствования. Они могут не улавливать тонкости исторических обстоятельств и культурных особенностей, что приводит к недочетам в результатах.

[ad_2]

Источник